Testez votre robots.txt

Bloquez les mauvais bots, autorisez les bons

Le renouveau de ce bon vieux robots.txt

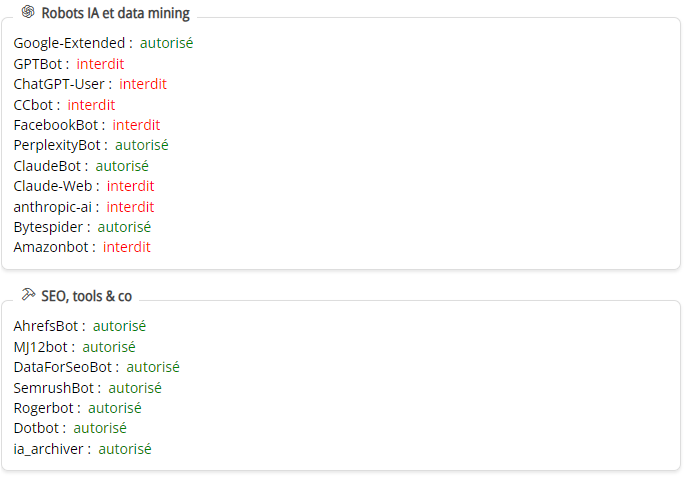

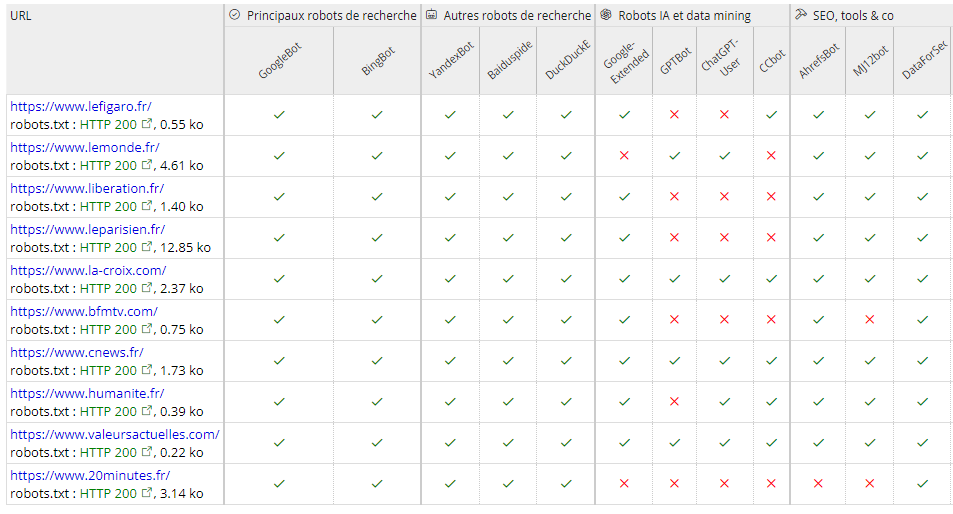

Placer un fichier robots.txt à la racine de son site permet de dire aux robots qui explorent le web s'ils sont autorisés ou non à fouiller dans nos pages. Jusqu'à l'émergence des IA génératives, les SEO utilisaient avant tout ce fichier pour empêcher l'exploration de pages qui n'ont rien à faire sur un moteur de recherche comme des pages d'administration en jouant avec les règles allow et disallow. Les bots IA ont redonné en 2024 une actualité brulante à ce petit fichier. Selon les directives qu'il contient, il peut en effet interdire aux bots IA de venir se nourrir de vos contenus. Beaucoup de gros éditeurs français ont déjà mis en disallow les user-agent utilisés par ChatGPT ou Gemini... à moins qu'ils aient passé des accords rémunérateurs avec ces plateformes. Et vous, quelle est votre politique ?

Un outil dans le pur esprit Alyze

Avec cet outil simple, gratuit et sans blabla inutile, vous allez pouvoir tester en un instant si une page peut être explorée par les robots de Google et Bing, mais aussi si elle autorise les robots des grandes IA génératives à s'entrainer sur son contenu et si elle est exploitable par les bots d'outils chers aux SEO comme Ahref, Moz ou Semrush.

Protéger vos contenus et préserver vos ressources avec le fichier robots.txt

Contrôler les bots des moteurs de recherche

Limiter l'exploration par les moteurs de recherche des parties sensibles ou inutiles de votre site reste l'usage principal du fichier robots.txt. Un fichier robots.txt bien configuré est gage d'une économie de ressources pour vous et les moteurs de recherche.

Limiter les robots qui nourrissent les IA

Les IA génératives doivent s'entraîner sur des quantités de textes importantes pour pouvoir fournir des résultats satisfaisants. Le web est devenu leur terrain de jeu. En explorant votre site, elles apprennent plein de choses qu'elles seront capables de restituer, mais généralement sans vous citer. Cela vous dérange ? Ça tombe bien, on commence à bien connaître les user-agent qu'elles utilisent.

S'adapter aux outils qui explorent le web

Beaucoup de plateformes proposent avec plus ou moins de succès et de précision de suivre les liens qui pointent vers vos pages ou les sites qui utilisent vos mots-clés. Cela nécessite de crawler le web avec intensité. Certains de ces robots peuvent d'ailleurs se révéler agressifs pour vos serveurs. Bloquer les user-agent de ces robots peut parfois être utile.

Jusqu'à 100 URL par requête

N'oubliez pas...

La bonne indexation de vos pages ne dépend pas que du fichier robots.txt. Si les balises meta robots peuvent notamment donner des directives capitales en la matière, c'est la qualité générale de votre contenu et son degré d'optimisation SEO qui feront que vos pages seront non seulement indexées (c'est-à-dire, présentes dans l'index Google), mais aussi et surtout bien positionnées et visibles dans les résultats de recherche. Pour vérifier ces paramètres, la recette est toujours la même sur Alyze : faites un audit SEO avec notre analyseur de page et une analyse de SERP pour bien comprendre comment se positionner sur vos requêtes.